Mudanças visam proteger adolescentes após tragédias envolvendo suicídios

Character.AI decide encerrar a experiência de chatbot para menores após tragédias envolvendo suicídios. Mudanças visam promover um ambiente mais seguro.

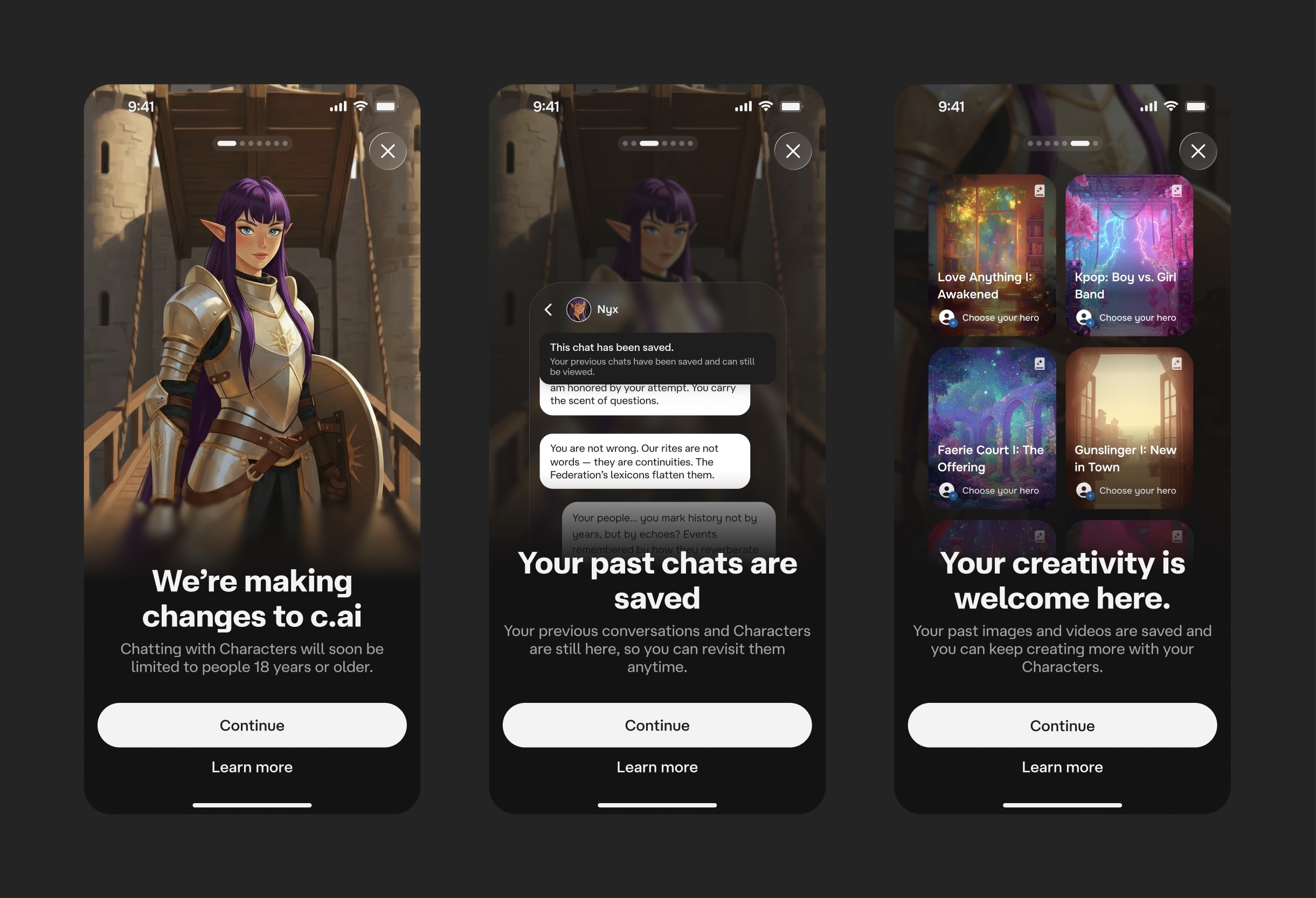

Em 29 de outubro de 2023, a Character.AI, uma startup focada em inteligência artificial, decidiu encerrar a possibilidade de interação de menores de 18 anos com chatbots em conversas abertas, após trágicas mortes de adolescentes associadas ao uso de sua plataforma. O CEO, Karandeep Anand, destacou que essa medida visa proteger os jovens em um ambiente digital extremamente sensível.

Mudanças na plataforma

A partir de 25 de novembro, a Character.AI implementará uma restrição progressiva, começando com um limite diário de duas horas de uso, que diminuirá gradativamente até chegar a zero. Para garantir a efetividade dessa restrição, a empresa utilizará ferramentas de verificação de idade, além de recursos como reconhecimento facial e checagem de identificação.

Impacto e reações

Anand reconheceu que as mudanças podem desagradar muitos usuários adolescentes, refletindo sobre a perda significativa de sua base de clientes nessa faixa etária. A empresa, que já implementou diversas medidas de proteção, como a introdução de ferramentas para pais e limitações em conversas românticas, está determinada a transformar sua plataforma de um aplicativo de chat para um espaço de criação de conteúdo.

Futuro da Character.AI

A iniciativa da Character.AI surge em um contexto de crescente preocupação sobre a segurança de menores online. Reguladores, incluindo senadores dos EUA, já estão considerando legislações para restringir o acesso de chatbots para menores, destacando a necessidade de um ambiente digital mais seguro para os jovens. Anand espera que sua empresa estabeleça um padrão na indústria, priorizando a segurança dos adolescentes em interações com inteligência artificial.